5月29日,英伟达发布DGX GH200人工智能(AI)超级计算机,将AI领域热度带向新高峰。ChatGPT等生成式AI的普及,催生巨量算力需求,带动英伟达GPU缺货涨价,重点型号A800的交货周期从1个月拉长到3个月,且价格上涨到10万元。由于GPU短缺,不少应用端企业开始内部配给算力,将资源集中到最有价值的项目上。

从当前的GPU市场足可看出AI领域已成为新风口,各大企业不容错失。不只是GPU,这轮AI风潮将带动产业链整体迭代升级,包括存储器、电源器件等关键环节,都将迎来更新换代和需求大增的机会。

GPU:赶上AI风口,但竞争激烈

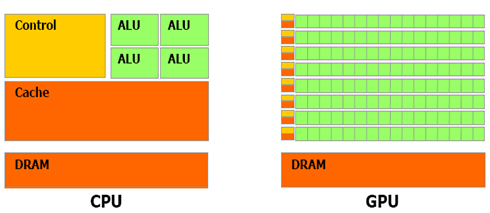

GPU(Graphics Processing Unit,图形处理单元) 本是为弥补CPU在图形处理能力上的短板而生。从两者架构来看,CPU算术运算单元(ALU)数量很少但性能足够强大,辅以大缓存(Cache)擅长完成复杂的逻辑运算。而GPU的架构与CPU刚好相反,其小而多的ALU外加更小的缓存,适合算量庞大且高度统一的纯计算任务,以及并行任务。

CPU与GPU架构对比 来源:NVIDIA CUDA技术文档

生成式AI需要庞大的训练量构筑模型,显然GPU更适宜执行此类任务。英伟达率先发明GPU,且一直是该领域的领导者。早在2016年,英伟达就开发出装载8枚P100芯片的超算DGX-1,并将其提供给ChatGPT的创始公司OpenAI。七年后的今天,ChatGPT全球瞩目,生成式AI开发一时间炙手可热,英伟达GPU产品需求飞速增长。

最近,服务器相关业者透露,A100/A800/H100等芯片模组供不应求,英伟达在手订单超过10万台,除下单量达到5位数的微软、谷歌等大客户,其他客户都要等到年底才能拿到芯片。这一巨大需求已经改变芯片生产链的安排。业界透露,英伟达原定于今年第四季度才会大批占用台积电晶圆以及CoWoS封装产能,目前已改为二、三、四季度平均占用,由此每月平均可多排出1000-2000片产能给英伟达。

虽有大批订单在手,但这并不能说明英伟达具有完全的市场统治力。正如其CEO黄仁勋所言,AI芯片的竞争非常激烈,不少客户一边用着英伟达的GPU,一边又在自研AI芯片。例如微软就正在自研名为“雅典娜”的AI芯片,谷歌也没有停下自研TPU的步伐。而在国内,寒武纪、景嘉微、海光、兆芯等也加入竞争,追求AI产业链自主度的提升。

但不论英伟达的GPU,亦或其他企业研制的ASIC、TPU等芯片,其算力规模都对整体系统的适配提出了新要求,其中,高数据吞吐量造成的“内存墙”问题,以及高能耗带来的电源系统优化问题,都是亟待解决的痛点,针对它们的解决方案将带火一批“芯”网红。

HBM内存:帮助AI服务器突破“内存墙”瓶颈

生成式AI在训练模型和生产内容时,会产生巨量数据吞吐,数据通过较窄带宽就会出现“内存墙”效应,以往的GDDR内存方案对此显得力不从心,而这正是HBM (High Bandwidth Memory,高带宽存储器)发挥优势的领域。

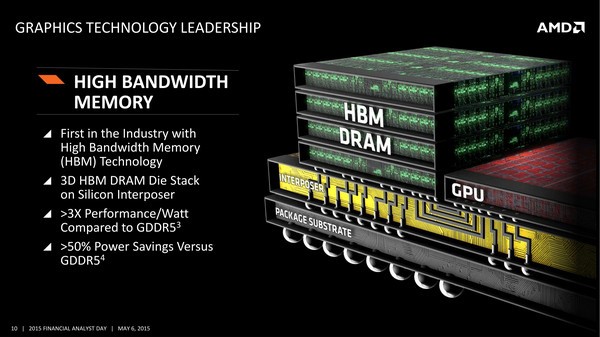

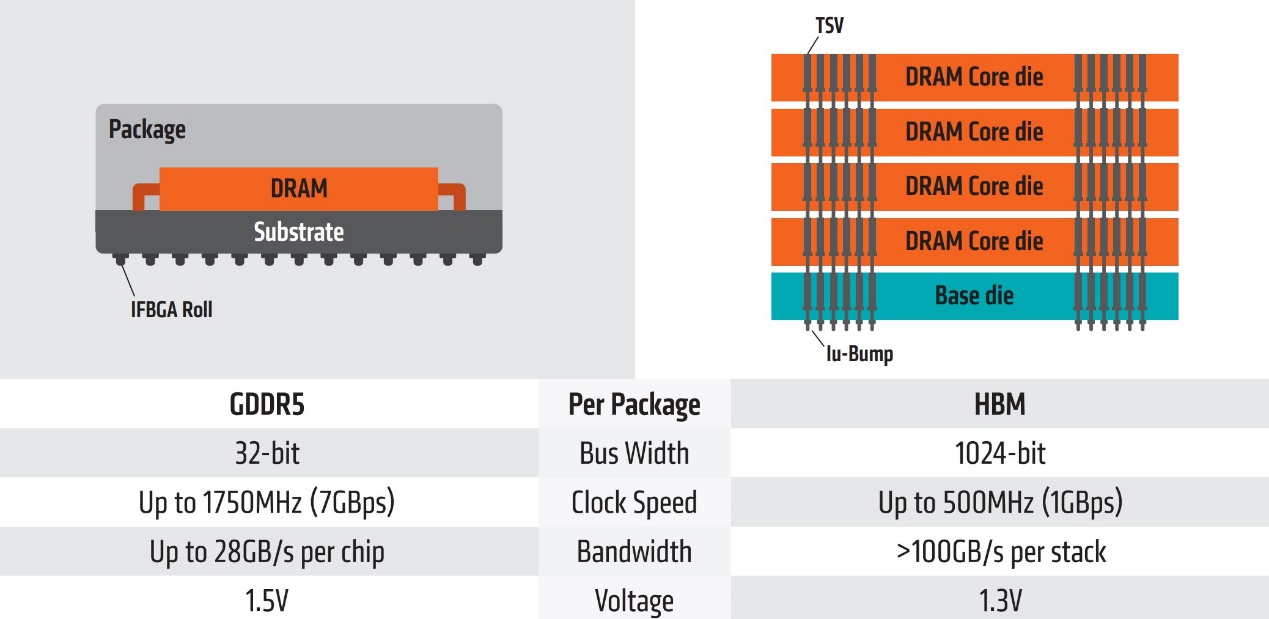

HBM最早由三星电子、SK海力士和AMD三家公司定义,它与GDDR等内存相比有两大优势,一是HBM与GPU、CPU等主运算芯片一同封装,距离近了,响应速度自然更快;二是HBM采用立体结构,能够纵向发展出更多内存空间。HBM这两大优势产生的最直观效果就是其远超GDDR的带宽。例如4层DRAM堆叠而成的HBM内存,其显存位宽是1024-bit,而GDDR5每通道位宽仅为32-bit。由此可见,HBM确实是AI服务器突破“内存墙”瓶颈的利器。

HBM内存结构示意 来源:AMD

但HBM与GDDR相比,并非没有短板。在容量上,HBM受限于集成封装,即便单片内存堆叠8层DRAM,在单个算力芯片内封装4个HBM内存,其总容量不过32GByte。而GDDR可在主板上使用扩展插槽,能轻松做到远高于32GByte水平,甚至达到128GByte也不是问题。

GDDR与HBM内存的指标对比 来源:AMD

当然,内存设计可将HBM带宽优势与GDDR容量优势结合,将二者整合到一个系统中,也是可行的方案。但不论如何,HBM在攻克“内存墙”方面起到的关键作用,将使其市场需求量快速增长。TrendForce预估,HBM内存市场规模在2022-2025年的复合增长率有望达到40%-45%以上,至2025年其市场规模有望达到25亿美元。

相比DRAM每年800亿美元以上的规模,HBM的市场还较为狭小,但由于其市场需求快速攀升,在这一年多的存储跌价周期内仍然保持涨价。其中最先进的HBM3规格产品甚至涨价5倍。

由于高技术门槛和高成本等特点,HBM生产至今仍以大型存储原厂为主。其中最为强势的是SK海力士和三星两家韩系原厂,份额分别为50%和40%,第三位的美光份额占10%。而在国内,国芯科技和通富微电等企业,致力于在HBM封装方面实现突破。

DrMOS:AI时代不可或缺的高效电源方案

性能强大、响应迅速的AI服务器是算力的保障,但其巨大的能耗不容忽视。方正证券分析师研报指出,AI服务器的功率较普通服务器高6-8倍,对于电源的需求也将同步提升。华安证券分析师研报指出,通用型服务器只需要2颗800W服务器电源,而AI服务器直接提升为4颗1800W高功率AI服务器电源,成本由3100元飙升到12400元,大涨3倍。在全球节能减排浪潮的引导下,AI服务器势必引入更为高效的电源方案,尽量降低高功率带来的高能耗,这就为DrMOS行业提供了发展良机。

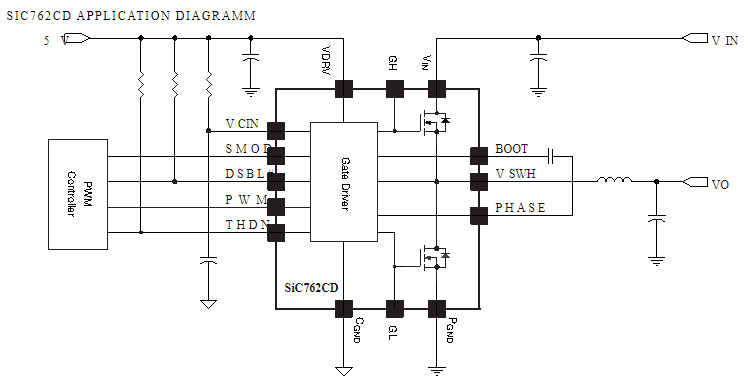

DrMOS(Integrated Driver & MOSFET,集成驱动器MOS),顾名思义,就是将多相供电电路中的高边MOS、低边MOS与驱动器封装到一起的元件。为适配算力越来越强的GPU、ASIC及FPGA芯片,以及愈发“寸土寸金”的PCB空间,用DrMOS取代分立式方案势在必行。唯有高集成度的方案,方可最大程度调和高性能与高能耗之间的矛盾。不仅如此,集成式方案还能让电路设计流程得以简化,从而节约AI服务器的开发与搭建时间。

DrMOS元件应用图示 来源:Vishay某产品Datasheet

DrMOS的产品形态最早由英特尔确立,应用在“高大上”的AI服务器上并非其首次亮相,其实它在台式机主板上早已广泛使用。DrMOS的主要供应商有MPS、Vishay、安森美、瑞萨及ADI等,国内供应商有杰华特、晶丰明源等。随着AI应用在国内的迅速发展,DrMOS展现出深厚的国产替代潜力。

调研机构Omdia的数据指出,2021年全球DrMOS市场规模约为9.56亿美元,预计到2026年将增长至11.22亿美元,2021-2026年的复合增长率为3.24%。而TrendForce预测今年全球服务器出货将增长38.4%,达到近120万台,同时,这一领域至2026年将保持22%的年复合增长率。两相比对,DrMOS的用量将以指数级攀升,其市场规模扩张速度会超过预想,相关厂商能够从中广为受益。

AI带动产业链全面“焕新”

AI超算要想发挥无与伦比的性能,相应的配套芯片也要升级换代,除了前述HBM内存和DrMOS之外,各类模拟、电源芯片也将迎来庞大的升级换代需求。不止IC,AI主芯片所用的封装载板、PCB等也将迎来大量高端需求。

总的来看,AI带动的产业链“焕新”是全局意义上的。可以想象,AI将与汽车电子共同弥补消费电子低迷导致的需求缺口,而这一轮风口转换,将会促进本就富有竞争力的大企业巩固优势,同时,新产生的赛道将催动一批中小企业实现突破。

关于IC交易网

IC交易网隶属于北京创新在线网络技术有限公司,成立于1999年,是国内首批电子元器件交易平台。始终秉持以“互联网+服务”为核心,积极推动电子产业上下游客户供应信息和需求产品的在线服务,形成了一整套完善的会员诚信体系,严苛的准入制度和信用评级,最大程度降低采购的风险,并通过多层次的认证审核机制,彰显业内极具影响力的企业,构建起可信赖元器件供应生态链。

历经二十余年的发展,IC交易网现拥有全球110万余家用户,日查询量300万次,有效库存1.05亿,有效产品型号1200万,每年元器件交易辐射数千亿人民币。未来,IC交易网将持续推进平台智能化建设,增强协同创新发展,高效推动电子行业上下游产业发展,全面提升电子产业链效率。